Spamhaus betreibt seit vielen Jahren einige der effektivsten Echtzeit-Blocklisten (DNSBLs) gegen Spam, Botnets und missbrauchte Mailserver. Viele Administratoren nutzen diese Listen über die klassischen öffentlichen DNS-Mirrors, etwa zen.spamhaus.org. Doch seit einiger Zeit schränkt Spamhaus die Nutzung genau dieser Public Mirrors deutlich ein.

Insbesondere gilt dies für Nutzer großer Hosting- und Cloud-Provider wie Hetzner oder OVH. Wer Spamhaus nun z.B. beim eigenen Mailserver mit diesen Providern einsetzt, wird im Log solche Meldungen entdecken:

Service unavailable; Client host [203.0.113.127] blocked using zen.spamhaus.org; Error: open resolver;

Die Legacy-Mirrors sind eigentlich nur für kleine Installationen gedacht, also für einzelne Mailserver, die klar identifizierbar über ihre eigene IP-Adresse sind. Doch genau diese eindeutige Identifikation funktioniert nicht mehr zuverlässig, wenn Anfragen über große Cloud-Infrastrukturen kommen. Damit kann die Fair-Use-Policy nicht mehr sinnvoll durchgesetzt werden.

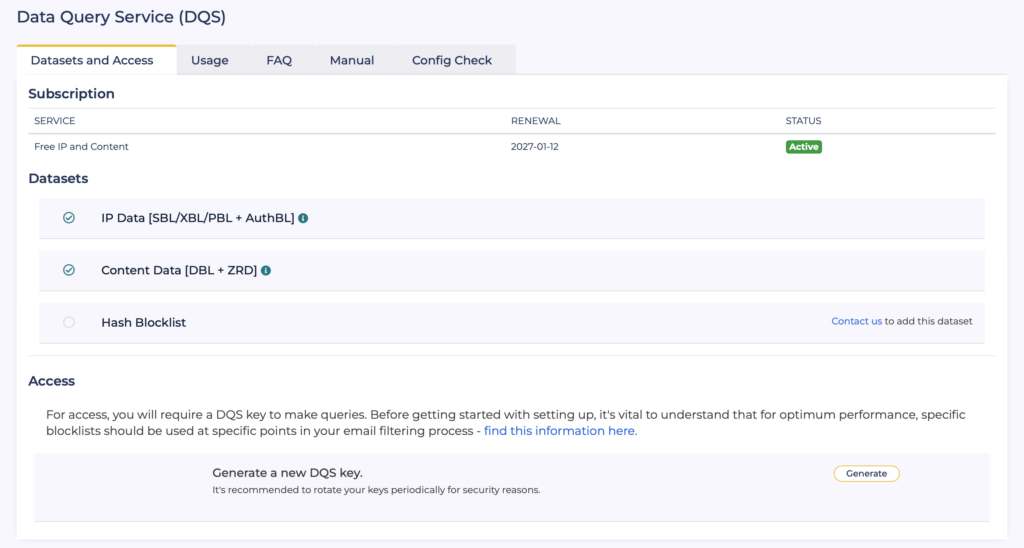

Als Alternative bietet sich der Spamhaus-Dienst Data Query Service (DQS) an. Damit werden die Abfragen weiterhin per DNS ausgeführt, jedoch über einen individuellen Zugangsschlüssel, der als Subdomain eingebettet wird und so eine eindeutige Identifikation ermöglicht. Im ersten Schritt muss hierfür ein Account angelegt werden. Nachdem der Account erstellt wurde, kann sich über das Portal eingeloggt werden. Dort kann unter dem Punkt Products → Data Query Service ein DQS-Schlüssel erzeugt werden.

Anschließend kann mit der Konfiguration von Postfix begonnen werden:

nano /etc/postfix/dnsbl-reply-map

In diese Datei wird Folgendes eingetragen:

dqskey.zen.dq.spamhaus.net=127.0.0.[2..11] 554 $rbl_class $rbl_what blocked using ZEN - see https://www.spamhaus.org/query/ip/$client_address for details dqskey.dbl.dq.spamhaus.net=127.0.1.[2..99] 554 $rbl_class $rbl_what blocked using DBL - see $rbl_txt for details dqskey.zrd.dq.spamhaus.net=127.0.2.[2..24] 554 $rbl_class $rbl_what blocked using ZRD - domain too young dqskey.zen.dq.spamhaus.net 554 $rbl_class $rbl_what blocked using ZEN - see https://www.spamhaus.org/query/ip/$client_address for details dqskey.dbl.dq.spamhaus.net 554 $rbl_class $rbl_what blocked using DBL - see $rbl_txt for details dqskey.zrd.dq.spamhaus.net 554 $rbl_class $rbl_what blocked using ZRD - domain too young

Der Platzhalter dqskey wird hierbei durch den realen DQS-Schlüssel ersetzt. Nach einer Ausführung von Postmap:

postmap /etc/postfix/dnsbl-reply-map

geht es an die eigentliche Konfiguration:

nano /etc/postfix/main.cf

Dort muss im ersten Schritt die alte Spamhaus-Konfiguration (wenn vorhanden) entfernt werden. Nun kann die neue Konfiguration hinzugefügt werden:

smtpd_recipient_restrictions =

...

reject_rbl_client dqskey.zen.dq.spamhaus.net=127.0.0.[2..11]

reject_rhsbl_sender dqskey.dbl.dq.spamhaus.net=127.0.1.[2..99]

reject_rhsbl_helo dqskey.dbl.dq.spamhaus.net=127.0.1.[2..99]

reject_rhsbl_reverse_client dqskey.dbl.dq.spamhaus.net=127.0.1.[2..99]

reject_rhsbl_sender dqskey.zrd.dq.spamhaus.net=127.0.2.[2..24]

reject_rhsbl_helo dqskey.zrd.dq.spamhaus.net=127.0.2.[2..24]

reject_rhsbl_reverse_client dqskey.zrd.dq.spamhaus.net=127.0.2.[2..24]

...

Damit die DQS-Schlüssel nicht per Reject-Nachricht nach außen geleakt werden, wird noch die Reply Map eingebunden:

rbl_reply_maps = hash:$config_directory/dnsbl-reply-map

Anschließend kann Postfix neu gestartet werden:

systemctl restart postfix

Getestet werden kann das Ganze dann z.B. mit dem Blocklist Tester von Spamhaus.