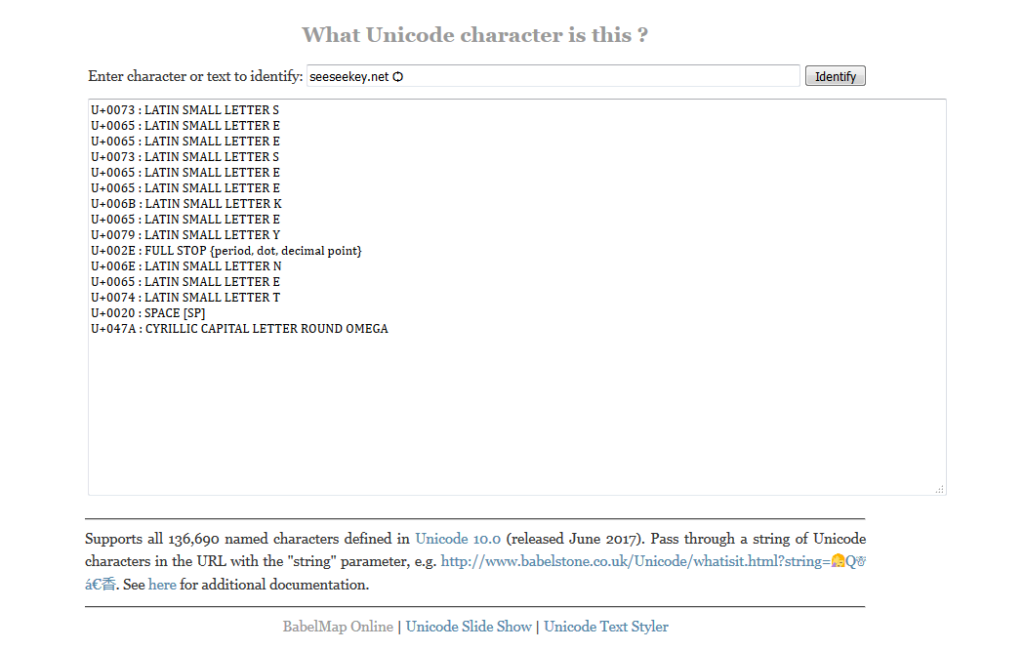

Viele Fonts decken einen gewissen Teil der Unicode-Zeichen ab. Wenn sich ein Zeichen im Text befindet, welches nicht dargestellt werden kann, so erscheint stattdessen das Zeichen �. Dieses Zeichen in der Umgangssprache Tofu genannt ist der Platzhalter für Zeichen, die in der Schriftart nicht enthalten sind. Beim Zeichen selber handelt es sich um das Notdef-Zeichen. Allerdings existiert mittlerweile ein Font, dessen erklärtes Ziel es ist keine Notdef-Zeichen mehr zuzulassen. Der Name des Fonts, Noto, steht für No More Tofu und stellt das Ziel des Fonts dar.

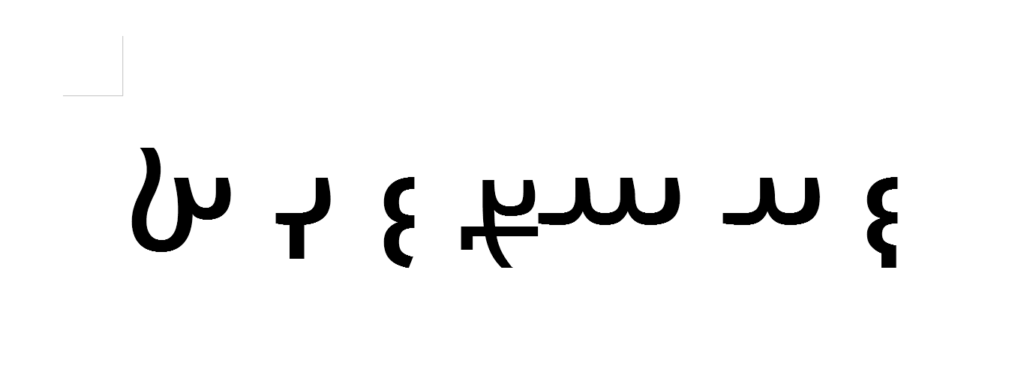

Unterschiedlichste Schriftsysteme werden unterstützt

Mittlerweile hat das Projekt einige Jahre Entwicklung hinter sich. 2011 gestartet werden über 64.000 Zeichen unterstützt, was in etwa die Hälfte der im Unicode definierten Zeichen ist. Dies schlägt sich allerdings in der Größe des Fonts nieder; im Moment belegt dieser knapp 1,5 Gibibyte auf der Festplatte. Deshalb ist er in unterschiedliche Dateien, mit den jeweiligen Schriftfamilien, aufgeteilt. Neben den unterschiedlichen Zeichen finden sich unterschiedliche Schnitte (wie z.B. Fett, Kursiv) im Font. Heruntergeladen kann der Font über die Projektseite von Google. Daneben kann die Entwicklung auf GitHub verfolgt werden. Lizenziert ist Noto unter der SIL Open Font License und damit freie Software.