Es gibt einige Webmail Clients unter freier Lizenz, wie z.B. Roundcube und SquirrelMail. Allerdings wird man feststellen, das die Auswahl nicht sonderlich groß ist. Ein neuer Stern am Webmail-Himmel ist Mailpile welches unter http://www.mailpile.is/ zu finden ist.

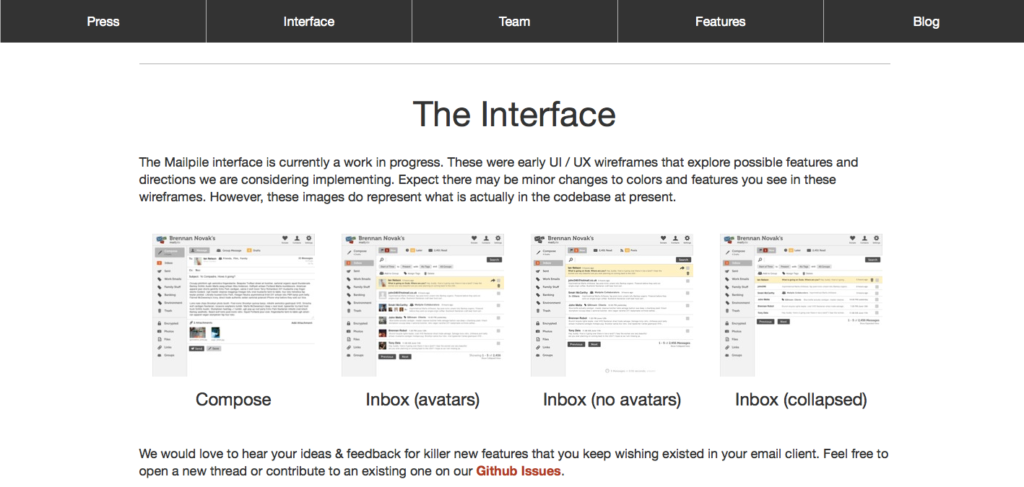

Mailpile orientiert sich dabei vom Interface her an Google Mail, was man auf den ersten Blick erkennt. Es bietet dabei natürlich Dinge wie eine Suche, verschiedene Importfunktionen, Tag-Support, eine Kontaktverwaltung und soll eine integrierte PGP Verschlüsselung und Signierung enthalten. Dadurch wird das ganze Paket wesentlich interessanter, da eine eingebaute Verschlüsslung, die Anwendung für Jedermann enorm vereinfacht.

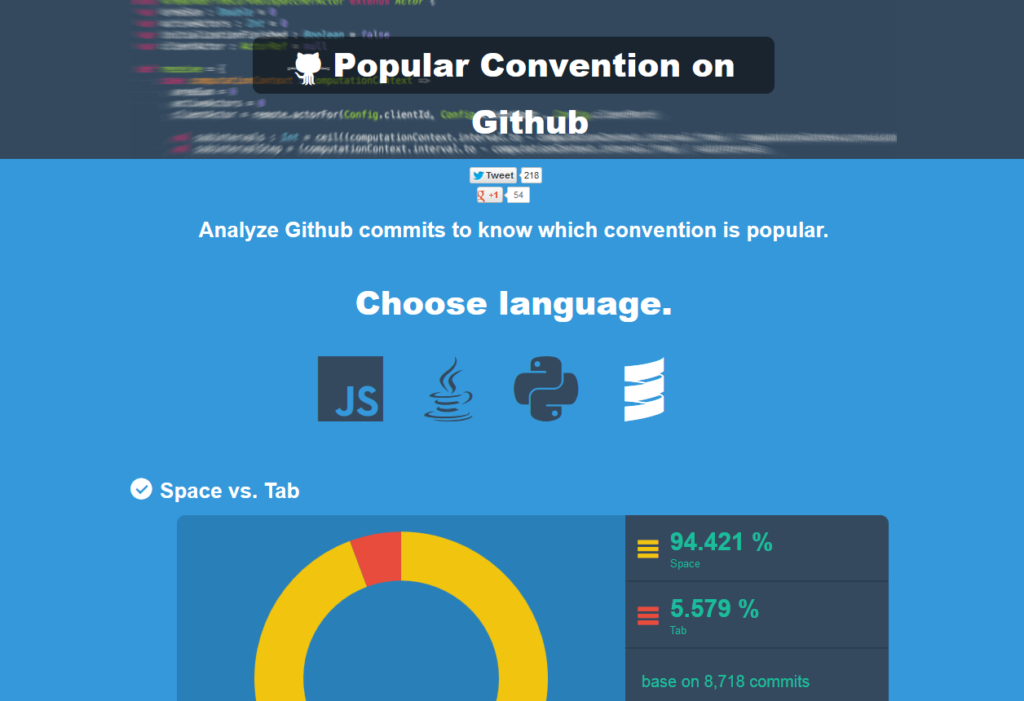

Für das Hosting benötigt man einen Pythonstack, so das es sich nicht für das normale LAMP Webhosting Paket eignet (es sei denn das P steht für Python). Das ist schade, da dadurch sicherlich der Kreis der Benutzer eingeschränkt ist. Mailpile ist freie Software und steht unter der AGPL. Der Quelltext ist auf Github zu finden. Im Moment wird auf Indiegogo Geld für die weitere Entwicklung des Clients gesammelt. Wem das Projekt also zusagt, sollte die Brieftasche zücken.